欢迎来到 AI 中文社区(简称 AI 中文社),这里是学习交流 AI 人工智能技术的中文社区。 为了更好的体验,本站推荐使用 Chrome 浏览器。

语言模型新范式:首个8B扩散大语言模型LLaDA发布,性能比肩LLaMA 3

2025-02-18 发布

·

浏览403次

·

点赞0次

·

收藏0次

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

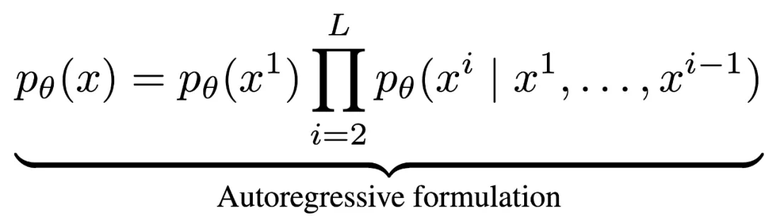

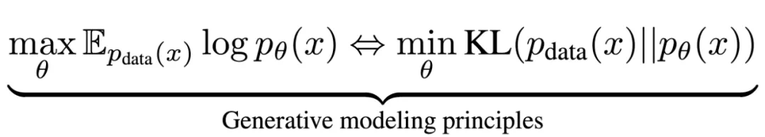

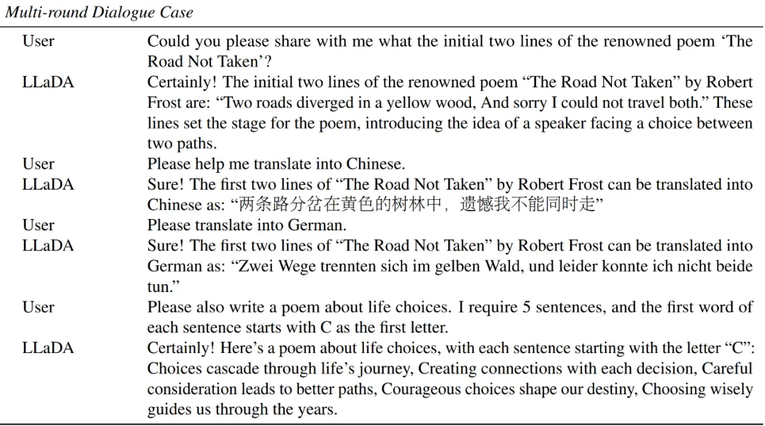

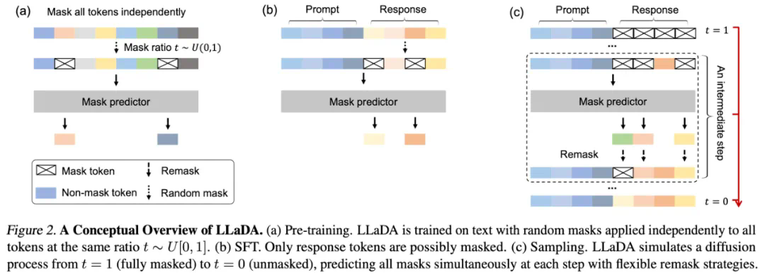

正是基于这一理念,团队开发了 LLaDA(Large Language Diffusion with mAsking)—— 一种基于掩码扩散模型的语言生成方法。与传统自回归模型不同,LLaDA 采用了前向掩码加噪和反向去噪的机制,不仅突破了单向生成的局限,还通过优化似然下界,提供了一种不同于自回归的、原理严谨的概率建模方案。

正是基于这一理念,团队开发了 LLaDA(Large Language Diffusion with mAsking)—— 一种基于掩码扩散模型的语言生成方法。与传统自回归模型不同,LLaDA 采用了前向掩码加噪和反向去噪的机制,不仅突破了单向生成的局限,还通过优化似然下界,提供了一种不同于自回归的、原理严谨的概率建模方案。

论文链接:https://arxiv.org/abs/2502.09992 项目地址:https://ml-gsai.github.io/LLaDA-demo/ 代码仓库:https://github.com/ML-GSAI/LLaDA

。在前向过程中,对文本

。在前向过程中,对文本 中的 tokens 进行逐步独立掩码,直到在 t=1 时整个序列被完全掩码。当

中的 tokens 进行逐步独立掩码,直到在 t=1 时整个序列被完全掩码。当 时,序列

时,序列 是部分掩码的,每个 token 有概率 t 被掩码,或者以概率 1-t 保留原样。而反向过程则通过在 t 从 1 逐步减小到 0 的过程中反复预测被掩码的 tokens,从而恢复出数据分布。LLaDA 的核心是一个参数化的掩码预测器

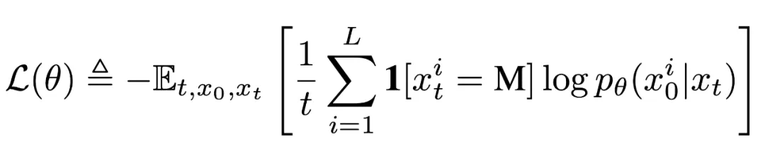

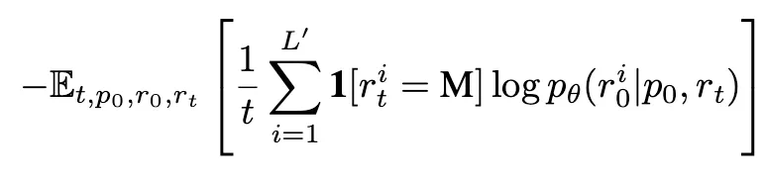

是部分掩码的,每个 token 有概率 t 被掩码,或者以概率 1-t 保留原样。而反向过程则通过在 t 从 1 逐步减小到 0 的过程中反复预测被掩码的 tokens,从而恢复出数据分布。LLaDA 的核心是一个参数化的掩码预测器 ,其训练目标仅对被掩码部分计算交叉熵损失:

,其训练目标仅对被掩码部分计算交叉熵损失:

,先随机采样

,先随机采样  ,然后以相同概率 t 对每个 token 进行独立掩码得到

,然后以相同概率 t 对每个 token 进行独立掩码得到  ,并通过蒙特卡罗方法估计目标函数

,并通过蒙特卡罗方法估计目标函数 进行优化。为增强对变长数据的处理能力,部分数据采用了随机长度。LLaDA 采用 Warmup-Stable-Decay 学习率调度器和 AdamW 优化器,设置总批量大小为 1280(每 GPU 4)。

进行优化。为增强对变长数据的处理能力,部分数据采用了随机长度。LLaDA 采用 Warmup-Stable-Decay 学习率调度器和 AdamW 优化器,设置总批量大小为 1280(每 GPU 4)。 进行训练,其中

进行训练,其中 为提示,

为提示, 为响应。在 SFT 中保持提示

为响应。在 SFT 中保持提示  不变,对响应

不变,对响应  进行独立掩码生成 ,然后计算如下损失:

进行独立掩码生成 ,然后计算如下损失:

为响应的动态长度。整个过程与预训练一致,只是所有被掩码的 token 均来自响应部分。SFT 在 450 万对数据上进行,使用类似预训练的学习率调度和优化器设置。

为响应的动态长度。整个过程与预训练一致,只是所有被掩码的 token 均来自响应部分。SFT 在 450 万对数据上进行,使用类似预训练的学习率调度和优化器设置。 ,模型从完全掩码的响应开始,通过离散化的反向过程逐步恢复文本。在每一步,模型预测所有被掩码 token 后,会按一定比例对部分预测结果进行再掩码,以保证反向过程与前向过程一致。对于条件似然评估,LLaDA 使用了下面这个和

,模型从完全掩码的响应开始,通过离散化的反向过程逐步恢复文本。在每一步,模型预测所有被掩码 token 后,会按一定比例对部分预测结果进行再掩码,以保证反向过程与前向过程一致。对于条件似然评估,LLaDA 使用了下面这个和 等价但是方差更小的目标函数:

等价但是方差更小的目标函数:

中均匀采样得到,

中均匀采样得到, 是通过从

是通过从  中不放回地均匀采样 l 个 token 进行掩码得到。

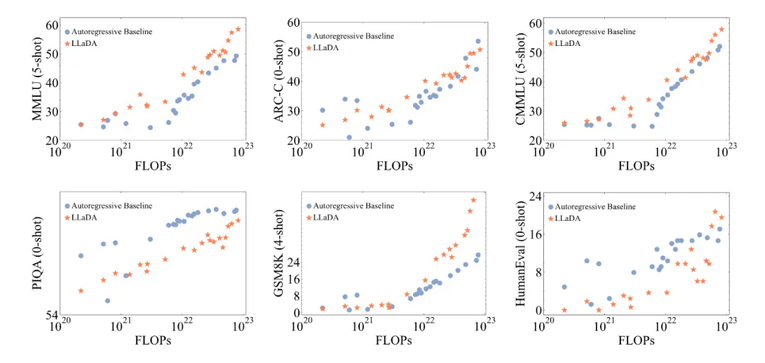

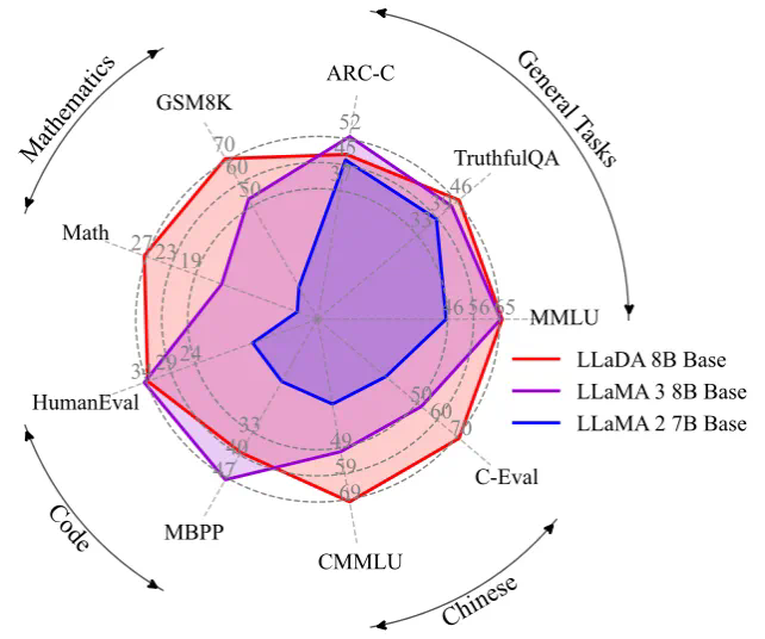

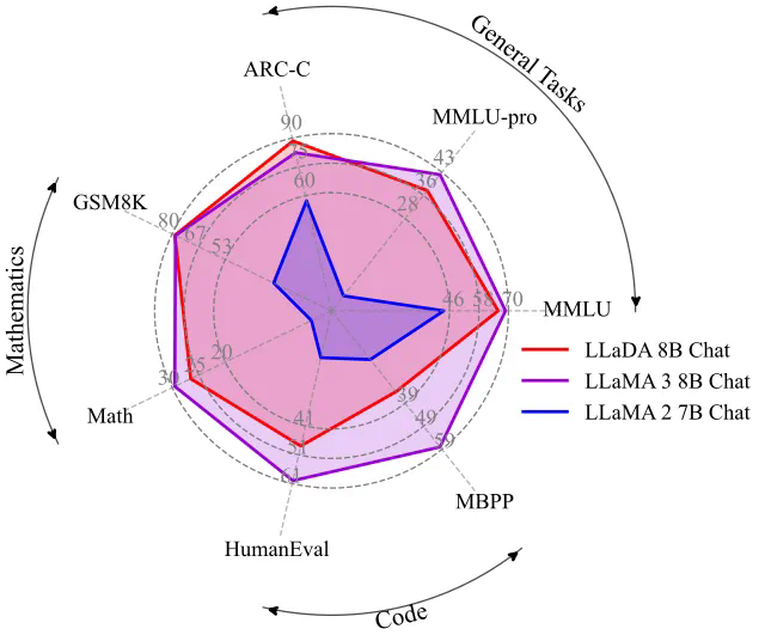

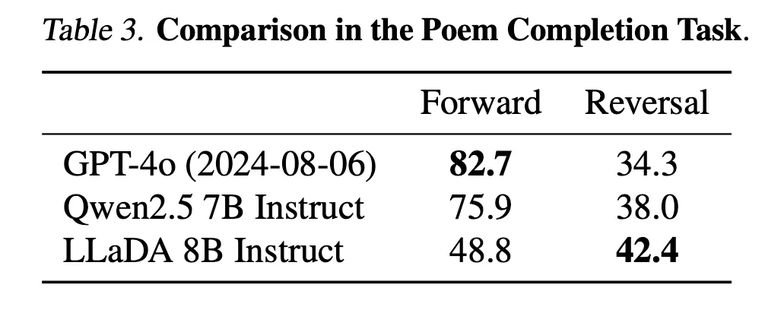

中不放回地均匀采样 l 个 token 进行掩码得到。扩散语言模型 LLaDA 首次展示了通过前向掩码加噪与反向去噪机制,同样可以实现大语言模型的核心能力。实验表明,LLaDA 在可扩展性、上下文学习和指令遵循等方面表现优异,具备与传统自回归模型相媲美甚至更优的性能,同时其双向生成与增强的鲁棒性有效突破了自回归建模的固有限制,从而挑战了「大语言模型的智能必然依赖自回归生成」的传统观念。

声明:本文转载自机器之心,转载目的在于传递更多信息,并不代表本社区赞同其观点和对其真实性负责,本文只提供参考并不构成任何建议,若有版权等问题,点击这里。

点赞(0)

收藏(0)

0条评论

珍惜第一个评论,它能得到比较好的回应。

评论

游客

登录后再评论

- 鸟过留鸣,人过留评。

- 和谐社区,和谐点评。

AI 中文社

AI 中文社