DeepSeek开源FlashMLA:Hopper GPU解码新标杆,测评大揭秘!

DeepSeek今天正式启动为期五天的开源成果发布计划,首个亮相的项目是FlashMLA。这一开源项目将先进的MLA算法与GPU优化技术相结合,为大模型推理提供了一套高性能、低延迟的解码方案。

FlashMLA是一款专门为Hopper GPU(比如H800 SXM5)优化的高效MLA解码内核,旨在加速大模型的计算任务,尤其是在NVIDIA高端显卡上提升性能。

通过FlashMLA,开发者能够在处理大规模语言模型时显著提高效率,降低延迟。与传统解码器相比,FlashMLA在处理可变长度序列时展现出更高的计算效率。

PPIO派欧云第一时间对FlashMLA在主流Hopper GPU(H20、H100、H200、H800)上的性能进行了评测。在深入了解评测结果之前,我们先来了解一下相关的背景知识。

科普时间:什么是Hopper GPU、解码内核和MLA?

•Hopper GPU:NVIDIA推出的新一代高性能GPU架构,专为AI和高性能计算(HPC)设计。它采用先进制程技术和创新架构,在复杂计算任务中提供卓越的性能和能效。主流的Hopper GPU包括H20、H100、H200和H800。

•解码内核:专门用于加速解码任务的硬件或软件模块。在AI推理中,解码内核能显著提升模型推理的速度和效率,尤其是在处理序列数据时。

•MLA:多头潜在注意力(Multi-head Latent Attention)的简称,MLA对KV缓存的需求更轻量化,使其在处理长序列时更容易扩展,同时性能也优于传统的多头注意力机制(Multi-Head Attention, MHA)。

FlashMLA性能实测

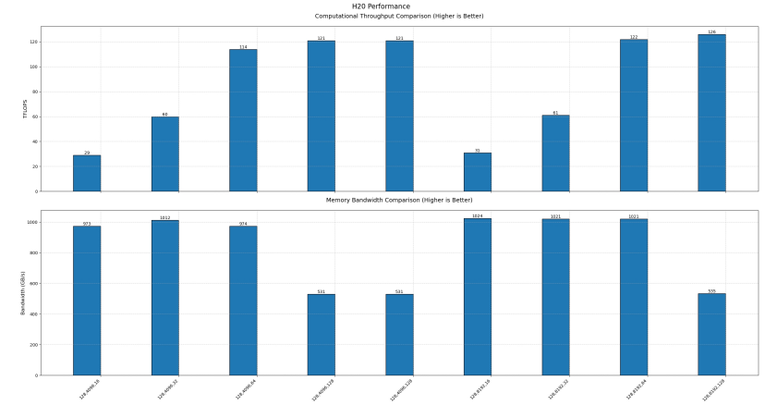

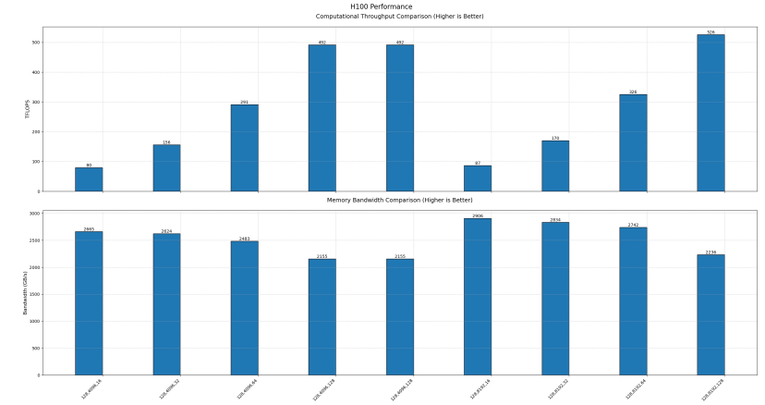

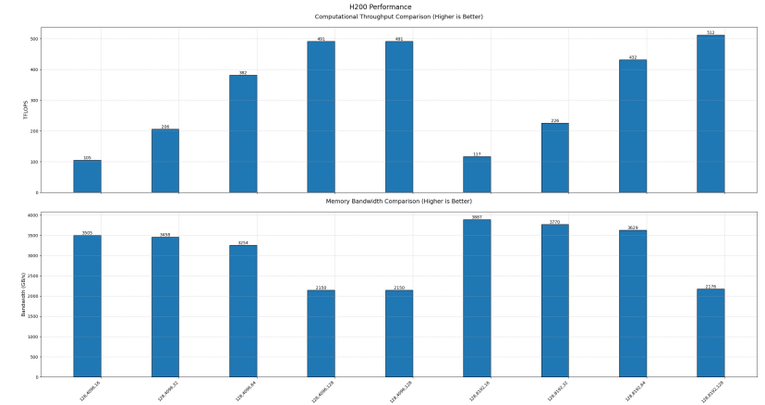

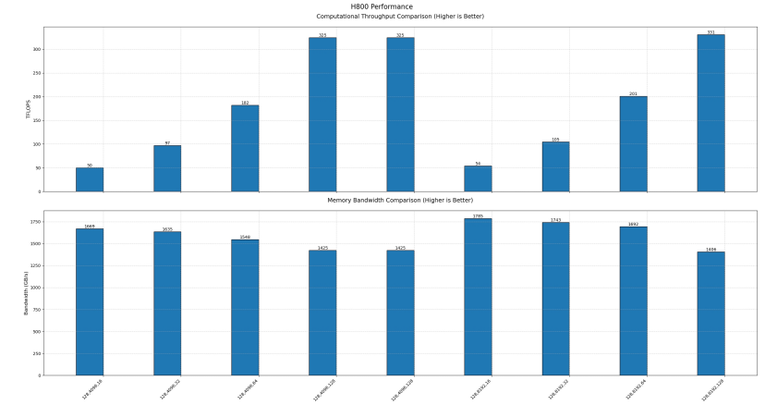

DeepSeek官方宣称,FlashMLA在H800 SXM5 GPU上可达到3000 GB/s的内存速度上限和580 TFLOPS的计算上限。在PPIO派欧云对FlashMLA的评测中,我们对不同参数配置下的性能进行了全面测试。为了更直观地展示结果,横坐标依次表示测试的参数配置,具体包括:

•批次大小(Batch Size)

•序列长度(Sequence Length)

•注意力头的数量(Number of Attention Heads)

评测结果如下:

•H20 GPU:内存速度上限为1024 GB/s,计算性能上限为126 TFLOPS。

•H100 GPU:内存速度上限为2906 GB/s,计算性能上限为526 TFLOPS。

•H200 GPU:内存速度上限为3887 GB/s,计算性能上限为512 TFLOPS。

•H800 GPU:内存速度上限为3000 GB/s,计算性能上限为580 TFLOPS。

本测试结果基于官方测试脚本。由于官方最优参数配置未知,数据可能未达到理论上限。

FlashMLA对主流推理框架的影响

FlashMLA的发布不仅吸引了开发者的目光,也引起了主流推理框架的重视。两大热门框架vLLM和SGLang都对FlashMLA做出了积极回应。

vLLM团队预计很快会实现集成FlashMLA。技术上,FlashMLA基于PagedAttention实现,与vLLM的技术栈高度兼容,集成后有望进一步提升vLLM的推理性能。

SGLang会继续用已经合并了的FlashInferMLA。根据他们的评测,FlashInferMLA的性能与FlashMLA基本相当。

声明:本文转载自机器之心,转载目的在于传递更多信息,并不代表本社区赞同其观点和对其真实性负责,本文只提供参考并不构成任何建议,若有版权等问题,点击这里。

游客

- 鸟过留鸣,人过留评。

- 和谐社区,和谐点评。

AI 中文社

AI 中文社